Einen prähistorischen Verhüttungsofen 3D drucken, Gelände abtasten und rekonstruieren – die prähistorische Archäologie arbeitet mit einer Vielzahl an digitalen Methoden. Philippe Della Casa – Professor an der Philosophischen Fakultät gibt uns einen Einblick.

Ich freue mich, dass wir heute über ein ganz spezielles Fachgebiet an der Philosophischen Fakultät sprechen können – Herr Della Casa, bitte stellen Sie sich kurz vor!

Mein Name ist Philippe Della Casa, ich bin Professor für Prähistorische Archäologie an der Philosophischen Fakultät der UZH – ehemals wurde das Fach Ur- und Frühgeschichte genannt. Meine Interessensgebiete liegen in erster Linie in der Vorgeschichte Europas, aber auch im interkontinentalen komparativen Bereich, wenn es z.B. um den Vergleich prähistorischer Gesellschaften geht, die in ähnlichen Rahmenbedingen in unterschiedlichen Gebieten lebten. Speziell interessieren mich hier als Schwerpunkt Berggesellschaften – in Englisch Mountain Archeology -; bei uns sind das spezifisch die Berggesellschaften in den Alpen. Wir haben aber auch Kooperationen und Projekte in anderen Bergregionen, z.B. in Bhutan, im Himalaya, auch viele Kontakte in die Pyrenäen, Karpaten oder in die Rocky Mountains und nach Feuerland.

Daneben definiere ich mich in erster Linie als Wirtschafts- und Gesellschaftsarchäologe, dabei liegt mein Schwerpunkt in der Siedlungs- und Landschaftsforschung und in der Art, wie Menschen mit ihrer Umwelt interagieren, welche gesellschaftliche Konstrukte vorhanden sind.

Könnten Sie für uns Laien kurz den Zeithorizont umreissen, in dem sich diese Forschung bewegt?

Meine Schwerpunktgebiete in Europa sind die sogenannten Metallzeiten, das ist ungefähr das 4. bis 1. Jahrtausend vor Christus – man könnte es auch so sagen: «Ötzi»-Zeit bis zum Ende der Eisenzeit, der keltischen Periode, d.h. bis zur Eroberung Galliens durch die Julius Caesar ca. 50 v.Chr.

Was für Berggesellschaften hat es in dieser Zeit in den Alpen? Ich kann mir gar nicht vorstellen, dass man da überleben konnte…

Das sind frühe alpine Bevölkerungen, die sich speziell auf die alpinen Rahmenbedingungen «eingelassen» haben und in diesem Umfeld auch wirtschaftlich interagierten. Diese Rahmenbedingungen sind z.B. die Steilheit des Geländes, eine starke Höhengliederung, klimatische Exposition, beschränkte Ressourcen, insgesamt Unsicherheiten und lange dauernde Winter.

Rahmenbedingungen wie für die heutigen Bergbauern…

Genau, in jener Zeit fing es etwa an, dass es erste dauerhafte Siedlungen in den Berggebieten gab. In den «Alpenfeldzügen» wurden dann die letzten aufmüpfigen Bergvölker durch Augustus besiegt und ins römische Reich integriert.

Welche digitale Methoden setzen Sie in der Prähistorischen Archäologie ein?

Es gibt ganz viele Anwendungsgebiete – ich werde heute drei Gebiete vorstellen:

Ein klassisches Anwendungsgebiet mit digitalen Methoden sind die «nicht-invasiven Prospektionen». Das können geophysikalische Prospektionen sein, die auf der Bodenoberfläche stattfinden. Dabei werden mit speziellen Geräten Widerstände gemessen, die ein Abbild unter dem Boden ergeben. Es können Strukturen erkannt, Dichteunterschiede gemessen werden uvm.

Es gibt aber auch luftbild- oder sogar satellitengestützte Prospektionen – hier ist man dann im Bereich des «Remote Sensing». Das bedeutet konkret, aus der Entfernung Oberflächen abzutasten: Das Erdinnere wird dabei nicht untersucht. Über die Oberflächenzeichnung kann man z.B. Grabhügel oder alte Wallanlagen entdecken. Häufig manifestieren sich über die Oberflächen jedoch auch Strukturen darunter. Ein gutes Beispiel sind Luftbilder von Kornfeldern: Hier kann man Strukturen erkennen, wie z.B. eine Mauer unter dem Boden, die bedingen, dass das Korn unterschiedlich wächst. Bildgebende Verfahren können diese Strukturen dann darstellen.

Was für Daten bekommt man aus diesen Methoden zurück, Zahlen, oder andere Formate?

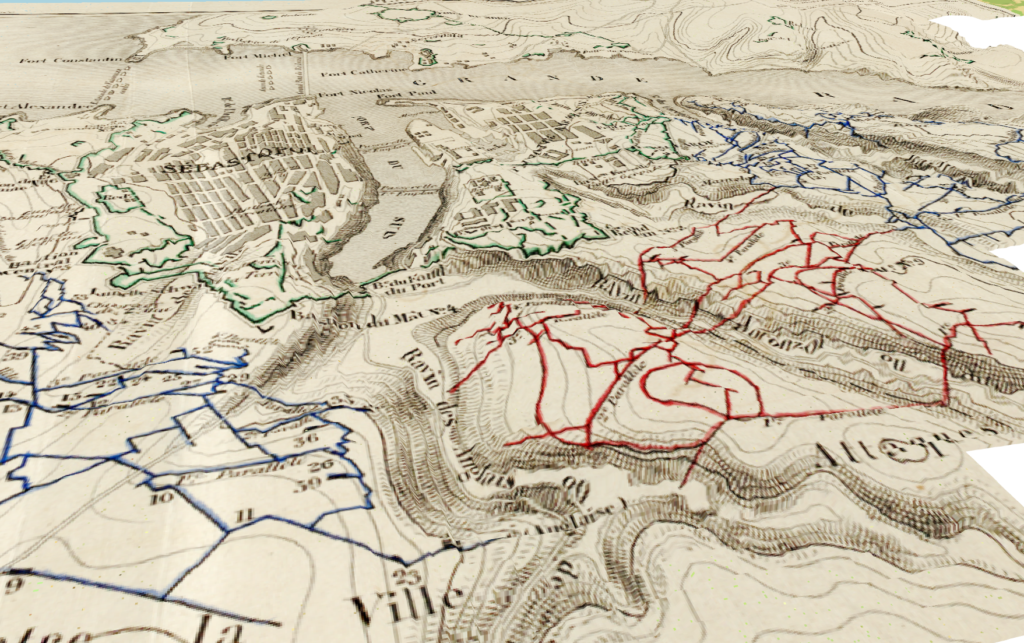

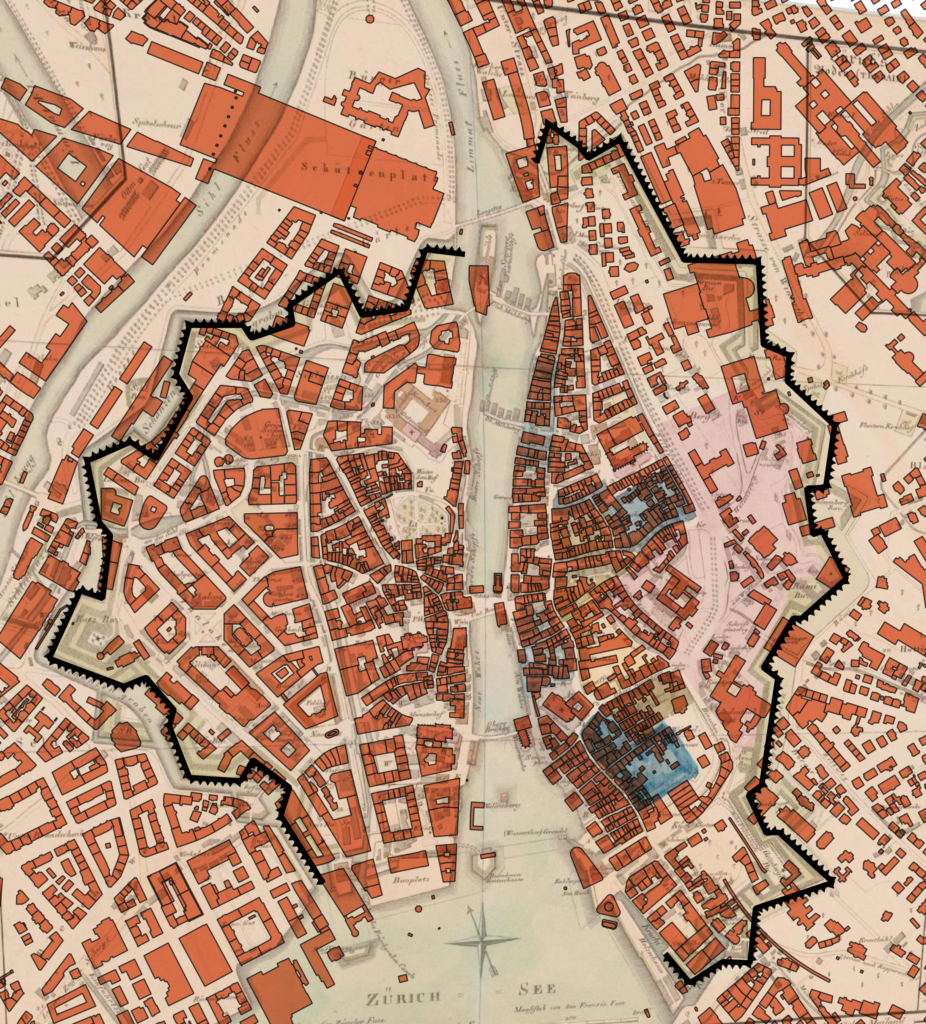

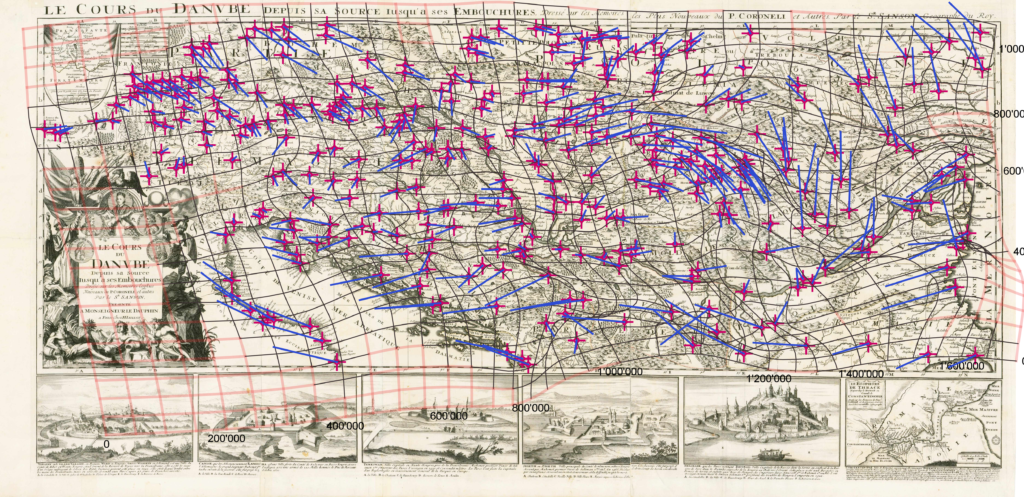

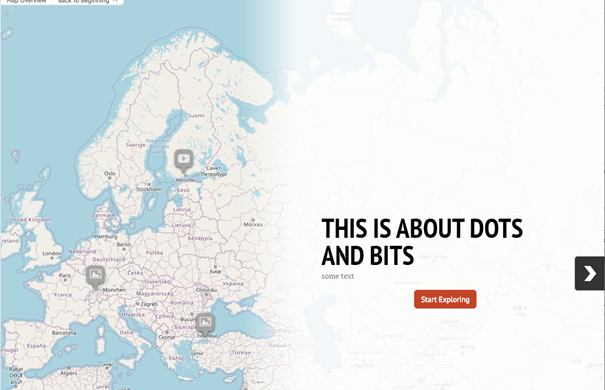

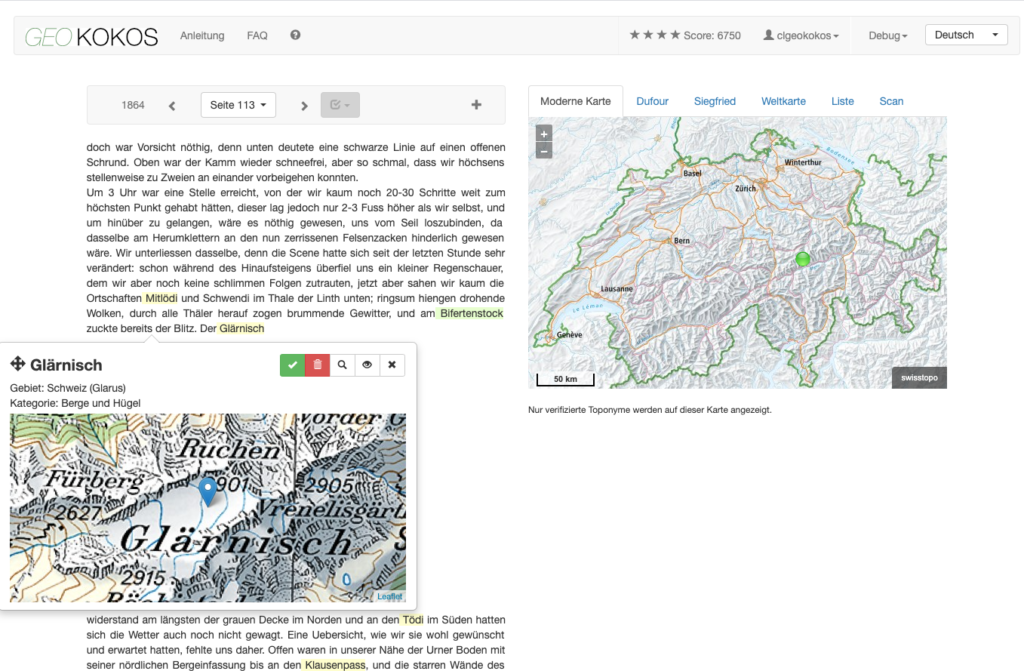

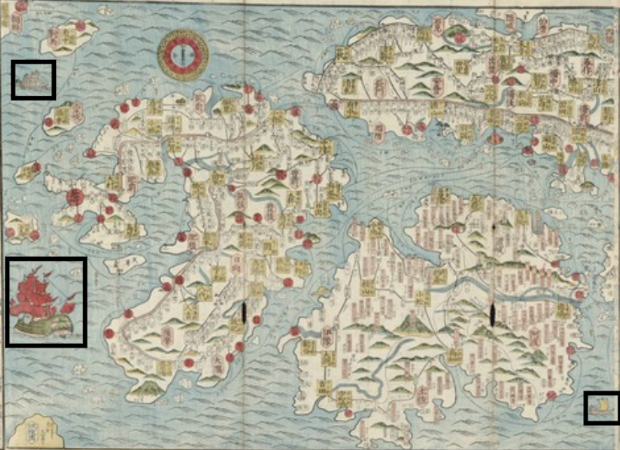

Ganz unterschiedlich natürlich, je nach Methoden. In unserem zweiten grossen Anwendungsgebiet, GIS (Geographic Information System), arbeiten wir mit herkömmlichen Datenformaten für Geodaten, die wir dann in ein GIS importieren können. So können wir die erhaltenen Daten als zusätzliche Layers auf Karten darstellen und analysieren.

Wir verwenden hier am Institut eine kostenpflichtige Software eines bekannten Herstellers, vermehrt und insbesondere die Studierenden aber auch Open Source Software – GRASS GIS und QGIS.

Teilweise importieren wir die eigenen Daten in das GIS und erstellen neue Karten, manchmal haben wir auch nur eine «physische» Karte und georeferenzieren diese dann im GIS manuell.

In der Disziplin gab es einen fliessenden Übergang, was den Einsatz digitaler Methoden angeht – in meinen ersten landschaftsarchäologischen Arbeiten habe ich Fundpunkte noch von Hand in physische Karten eingetragen, mittlerweile macht man das automatisiert vor Ort. Man sieht hier schön den Übergang von analogen zu digitalen Humanities.

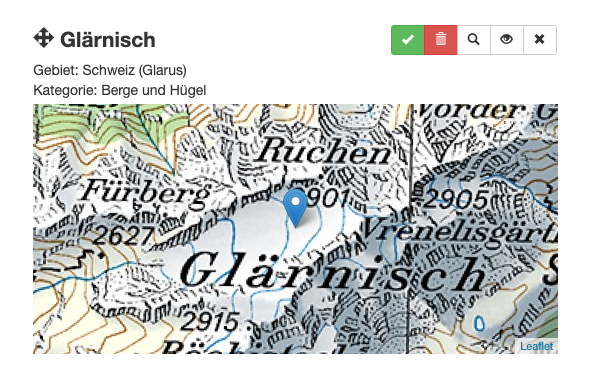

Für QGIS gibt es auch eine mobile App, mit der man Standorte georeferenzieren kann – wird diese auch eingesetzt?

Genau, das hat in den letzten Jahren angefangen und wird die Zukunft sein: Im Feld wird nicht mehr mit Papierdokumentation gearbeitet, sondern direkt mit dem Tablet. Die erfassten Daten können sofort im GIS integriert werden. Dies ist vielleicht nicht wahnsinnig spektakulär, erspart aber sehr viele Zwischenschritte.

Was ist das dritte Anwendungsgebiet?

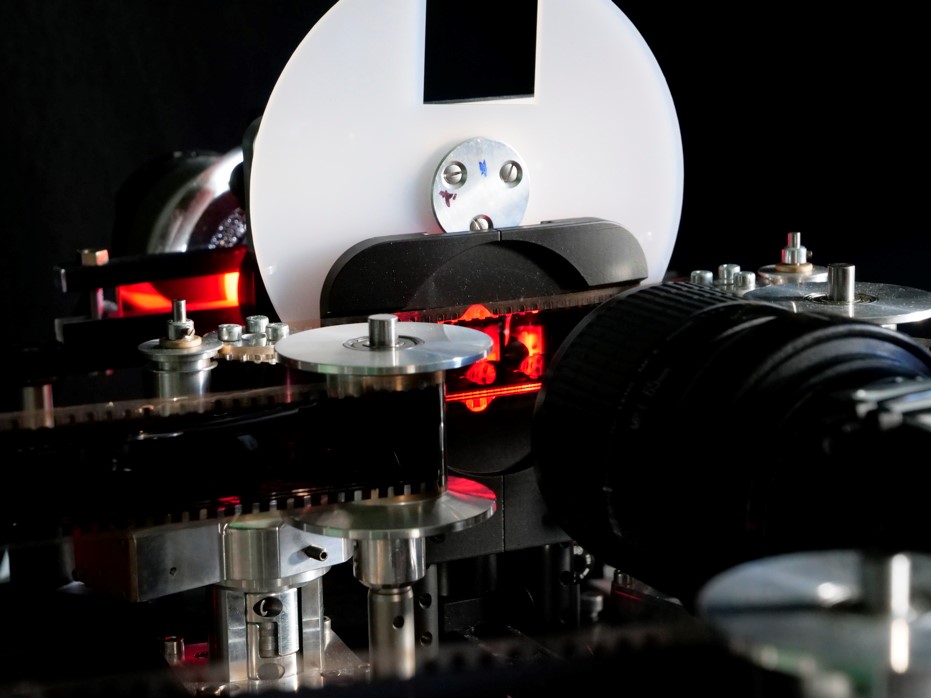

Ein drittes grosses Anwendungsgebiet sind 3D-Graphikrekonstruktionen: Modellierungen im 3D-Raum. Wir arbeiten z.B. mit Structure from Motion (SfM), einer photogrammetrischen Dokumentationstechnik. Man macht viele Fotografien einer archäologischen Fundstelle. Die Fotografien enthalten referenzierte Punkte, was erlaubt, mit einer speziellen Software ein 3D-Modell zu erstellen. Dieses Modell kann man entweder auf dem Bildschirm darstellen und manipulieren (drehen, zoomen, etc.), oder man kann es sogar mit dem 3D Drucker ausdrucken.

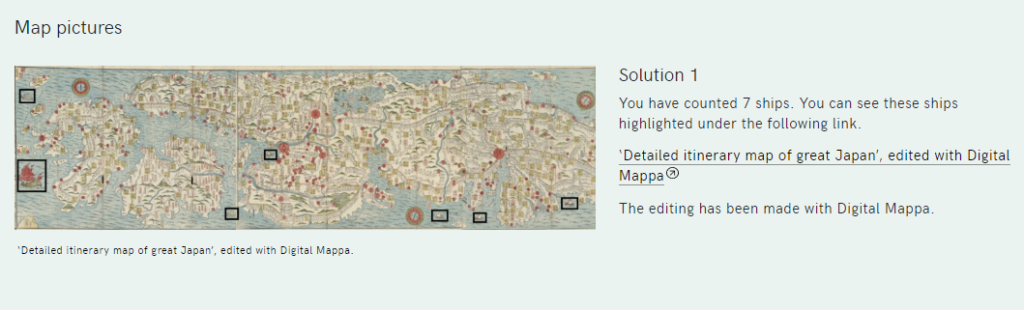

Für die Scientifica 2017 haben wir beispielsweise ein 3D Modell eines prähistorischen Ofens aus Daten eines Fundortes erstellt. Es handelte sich um einen Kupferverhüttungsofen aus dem 1. Jahrtausend im Bündner Alpenraum. Diesen haben wir ausgegraben, dokumentiert und mit SfM photogrammetrisch modelliert. Aus dem photogrammetrischen Modell konnten wir anschliessend mit dem 3D Drucker einen Miniatur-Verhüttungsofen drucken, mit dem man den Besuchern der Scientifica die Verwendung demonstrieren konnte.

Wie steigt man als Anfänger*in in diese Methoden ein – gerade bei der Bildverarbeitung passiert mathematisch ja einiges…

Die Archäologie ist ein gutes Beispiel für diese Problematik. Wir sind traditionell ein geisteswissenschaftliches Fach und bringen wenig mathematische Kenntnisse mit. Wir zeigen in einführenden Modulen Beispiele dieser Methoden, Anwendungen, gehen aber noch nicht auf den mathematischen Hintergrund ein. Dann bieten wir ganz vereinzelt Module wie «Computer Applications in Archeology» an, in dem dann tatsächlich die Aufgabenstellung und die instrumentellen Methoden angeschaut werden, bis zu einem gewissen Punkt auch die Algorithmen.

Aber: Die wenigsten schaffen dann den Schritt dazu, Algorithmen selber zu entwerfen, sondern bleiben Anwender z.B. der SfM-Software. Wir brauchen dann Partner an anderen Instituten, z.B. beim Institut für Geodäsie und Photogrammetrie an der ETH, die uns im konkreten Fall mit der Mathematik helfen können.

Selbst wenn wir digitale Grundlagen im Fach unterrichten wollten, könnten wir gar nicht, weil die Ressourcen für das Lehrpersonal nicht da sind. Wir ziehen manchmal ExpertInnen im Bereich «Digital Archeology» bei, doch das ist ja nur ein Beispiel von sehr vielen interdisziplinären Methoden. Gerade für aDNA- und Isotopenanalyse, Materialanalytik und sehr vielen weiteren Methoden, die in den letzten 20 Jahren entstanden sind, müssten wir SpezialistInnen haben. Die Methoden finden allenfalls Eingang in die disziplinären Projekte – bei der Lehre stehen wir vor der grossen Herausforderung, was davon aufgenommen werden soll und kann.

Beim Thema GIS wären Spezialistinnen und GIS-Module am Geographischen Institut vorhanden – doch diese sind oft komplett (aus)gebucht, so dass unsere Studierenden dort nicht andocken können. Dazu kommt, dass sie in der Anwendung in eine andere Richtung gehen, als wir in unserem geisteswissenschaftlichen Fach benötigen.

Wie haben Sie sich die digitalen Methoden erarbeitet, wie sind Sie dazu gekommen?

Ganz klar aus meinem Interesse auch für die Naturwissenschaften, der Science Archeology und natürlich durch die Entwicklung der letzten Jahre. Es ergeben sich Möglichkeiten, die man vorher mit den analogen Methoden nicht hatte.

In den Bereich Prospektion sind wir notgedrungen geraten: Grabungen auf dem Feld sind sehr aufwendig und ressourcenintensiv. Man produziert sehr viel Material, das gelagert, dokumentiert und konserviert werden muss, es ist auch administrativ sehr aufwendig, wenn es z.B. um Bewilligungen geht. Die Prospektion dagegen liefert sehr viele Resultate, ist aber viel weniger ressourcenintensiv. Man erhält zwar auch viele Daten, kontrolliert vor Ort aber nur noch fallweise, nicht mehr auf grösseren Flächen.

Mit dem Kanton Graubünden haben wir eine sehr gute Kooperation – doch dort können wir z.Z. keine Siedlungsgrabungen, d.h. Forschungsgrabungen in Siedlungen machen. Aufgrund der Bauaktivitäten gibt es bereits sehr viele Notgrabungen, ausserdem noch sehr viel unbearbeitetes Altmaterial. Prospektionen dagegen dürfen wir machen, die Funddaten liefern wir in die Fundstellendatenbanken des Kantons. Dies ist gut für den Kanton, weil sie dann wiederum ihre archäologischen Zonenkarten präzisieren können, um Verdachtsflächen zu ermitteln. Dadurch ist der Kanton im Idealfall bereits gut vorbereitet, wenn Bauprojekte beantragt werden. Von Gesetzes wegen müssen sie zwar dann Notgrabungen durchführen, doch es beschränkt sich auf die Verdachtsflächen und ist dadurch fokussierter und zielgerichteter.

Sie hatten einmal erwähnt, dass Sie auch predictive modeling machen – wie funktioniert das genau?

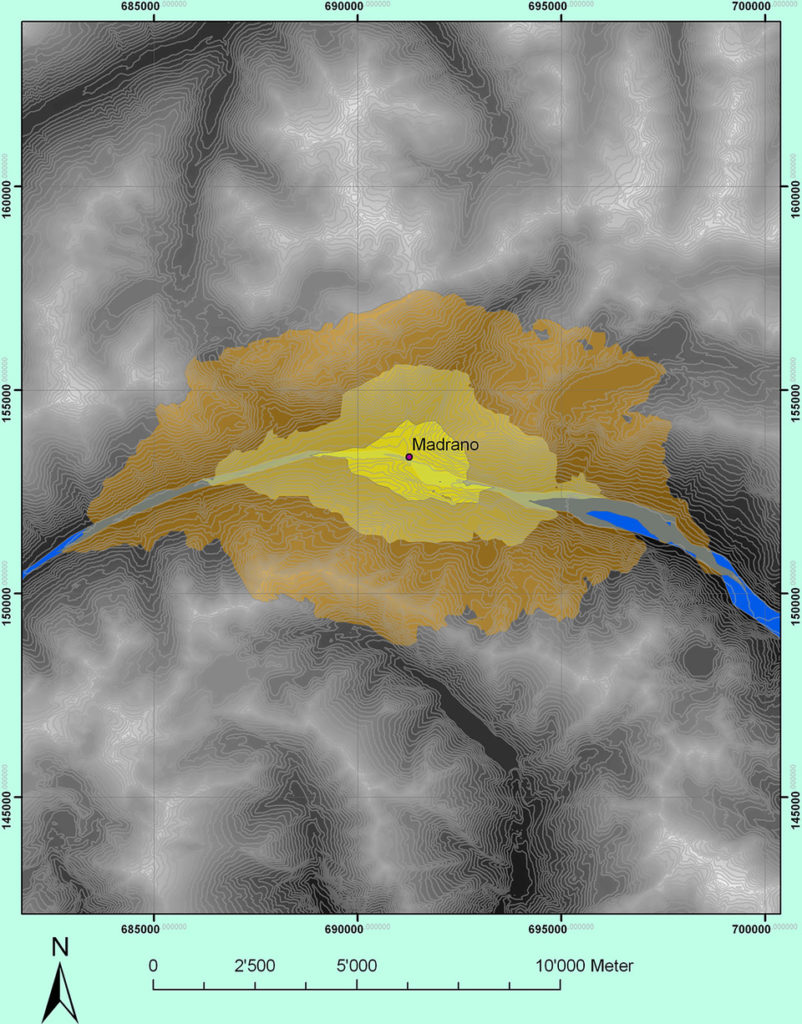

Das ist eine typische GIS Anwendung – wir kartieren und analysieren bekannte Fundstellen vor einem geoinformatischen Hintergrund: Das sind verschiedene Kartenlayer, z.B. Nähe zu Wasser, Bodenqualität, Hangneigung. Aus dieser Analyse leiten wir Principal Components, d.h. Hauptkomponenten von Siedlungssituationen ab (Principal Component Analysis). Wir finden dann vielleicht für typische bronzezeitliche Siedlungen heraus, dass diese auf Hügelkuppen, am Talrand, innerhalb dieser oder jener Vegetationsstufe etc. liegen. Mit einem Vergleich von ähnlichen Merkmalgruppen wird es nun möglich, mögliche Fundstellen vorherzusagen.

Dies ist eigentlich eine spannende Sache – ein grosser Nachteil ist aber, dass man immer nur erfasst, was man bereits kennt. Dagegen kann man aus ergebnisoffenen Prospektionen Fundstellenkategorien erfassen, die man vorher noch nicht kannte. Man muss also die Methoden gut kombinieren. Auch diese offenen Verfahren brauchen aber immer eine Überprüfung vor Ort, man nennt das «ground truthing».

Was müsste es bei uns an der UZH noch geben, damit die Archäologie all diese Methoden in die Lehre oder auch Forschung bringen könnte?

Es fängt bei einfachen Sachen an: Für einen geplanten GIS-Kurs suchten wir vor einigen Jahren einen entsprechend ausgerüsteten Schulungsraum, d.h. Computer mit installierter GIS Software. Die vorhandenen Räume an der MNF waren durchgehend ausgebucht…

Weiter fehlt eine geisteswissenschaftliche Grundausbildung für GIS. Die vorhandenen Module, abgesehen davon, dass sie überbucht sind, gehen immer in andere fachwissenschaftliche Richtungen. Um das zu erreichen, müssten sich an der Philosophischen Fakultät vielleicht verschiedene Institutionen zusammenschliessen – Historiker*innen, Archäolog*innen, Linguist*innen usw.

Ein anderes Thema, das eine grosse Rolle spielt, sind natürlich die Ressourcen: Die Archäologien sind sowieso schon recht teuer. Wir haben teure Feldmodule, wir haben teure Apparaturen, usw. Je mehr Spezialisierungen wir anbieten möchten, desto teuer werden unsere Module im Vergleich zu anderen Modulen der Fakultät.

Doch unser Problem ist, dass wir auf Feldforschung, Geräte oder Software einfach nicht verzichten können, wenn wir bei den «Digital Archaeologies» mithalten können wollen. Ein Beispiel: Für einen Arbeitsablauf in der Digital Archeology benötigt man vielleicht zehn Komponenten, Geräte oder Software, die im Zusammenspiel einen Workflow ergeben: Aufnahme im Feld mit Drohnen o.ä., Datenverarbeitung, Visualisierung etc. Gerade für solche scheinbar unzusammenhängenden Komponenten ist es schwierig, an Finanzierungen zu kommen, weil das Verständnis für die spezifischen Prozesse manchmal nicht da ist.

Ohne die Komponenten ist aber ein Einstieg in die digitalen Methoden gar nicht möglich – so wird man technisch abgehängt, nicht?

Gerade wenn man Digital Humanities fördern möchte, brauchen sie einen Stellenwert im Studienprogramm, etwa indem fachübergreifenden Strukturen geschaffen werden oder in der Fakultät Cluster gebildet und mit Ressourcen ausstattet werden. Ich denke da auch an Lehrpersonal – ich würde natürlich morgen eine Dozent*in mit Spezialgebiet «Digital Archeology» anstellen, wenn ich könnte.

Man darf nicht vergessen, dass die Archäologie ein konkretes Anwendungsfeld hat. Wir bedienen Kantonsarchäologien, die einen Öffentlichkeitsauftrag haben, mit fachwissenschaftlichem Nachwuchs. Es ist nicht nur eine geisteswissenschaftliche Disziplin, sondern gewissermassen auch eine Berufs(aus)bildung. Deshalb müssen wir sicherstellen, dass wir methodisch und technisch nicht hinterherhinken. Auch wenn wir nur 24 Kantone und sogar etwas weniger Kantonsarchäologien haben, und wir nicht hunderte von Studierenden für diesen Markt ausbilden können, benötigen wir dennoch Ressourcen, um eine angemessene Ausbildung bieten zu können.

Wir haben eine Verpflichtung gegenüber dem kulturellen Erbe der Schweiz, wenn nicht gegenüber der Menschheit, dass wir Leute ausbilden, die in der Lage sind, das Management dieses kulturellen Erbes auf allen Stufen wahrzunehmen, vom Boden bis zur Rekonstruktion.

Vielen Dank für das Gespräch!

Links:

Wikipedia: Structure From Motion

Scientifica 2017: Verhüttungsofen

[Tilia Ellendorff, TE]: Mein Name ist Tilia Ellendorff. Ursprünglich habe ich Grundschullehramt mit den Fächern Englisch und Deutsch studiert an der Universität Paderborn. Anschliessend habe ich mich aber entschlossen, mich auf Linguistik und Computerlinguistik zu konzentrieren – zunächst mit einem Bachelor in Linguistik, dann mit einem Internationalen Masterstudium in Computerlinguistik in Wolverhampton (GB) und Faro (P), über Erasmus Mundus. Schliesslich bin ich für das Doktorat in Computerlinguistik nach Zürich gekommen. Mein Thema war Biomedical Text Mining – in meinem Projekt ging es darum, in medizinischen Publikationen die Beziehung zwischen ätiologischen, also auslösenden, Faktoren von psychiatrischen Erkrankungen zu extrahieren. Hier besteht nämlich das Problem, dass es unmöglich ist, die gesamte Literatur auf diesem Gebiet zu lesen. Es ist schwierig, so einen Überblick über alle Faktoren zu gewinnen. Ich habe dazu ein System gebaut, das dies unterstützt und automatisch aus den Texten extrahiert.

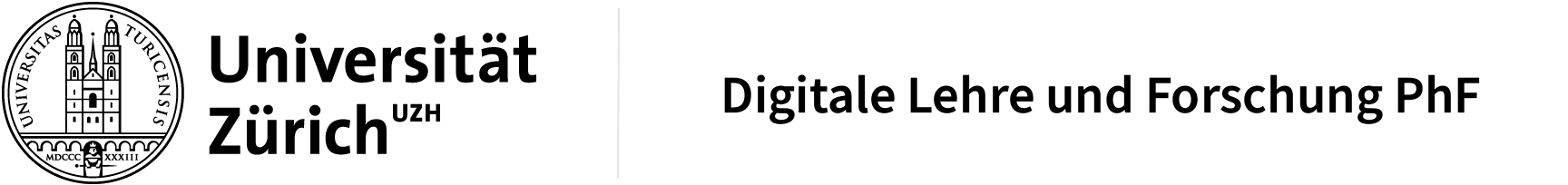

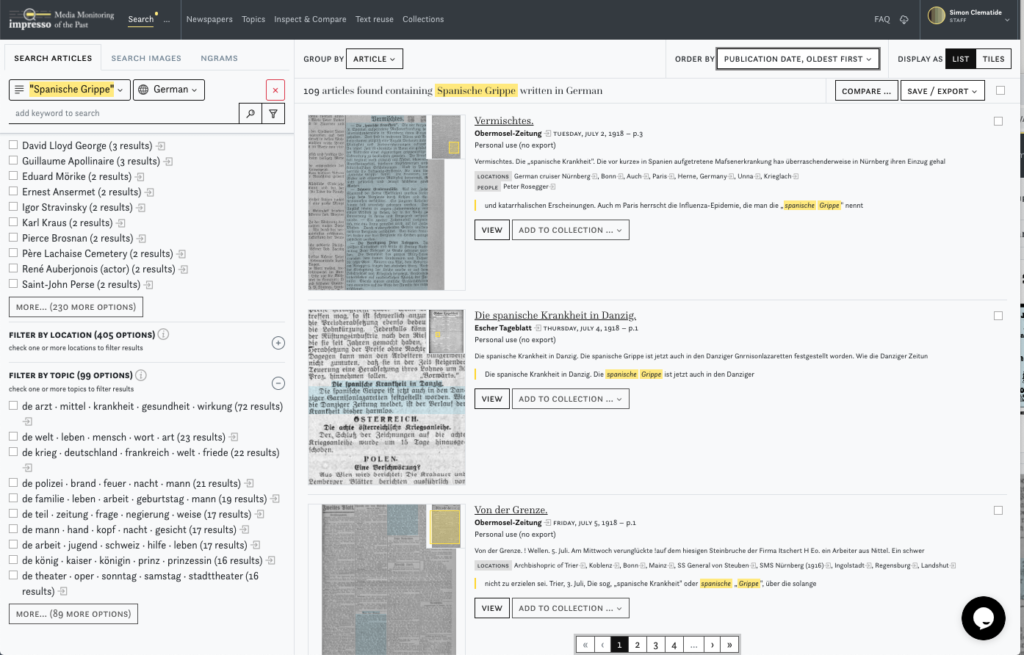

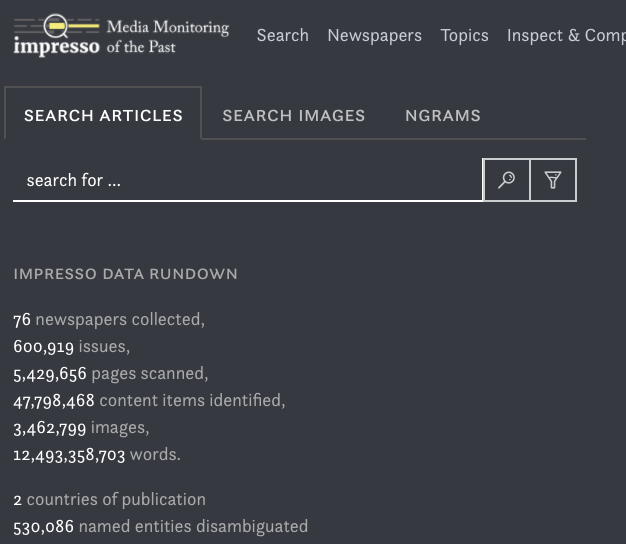

[Tilia Ellendorff, TE]: Mein Name ist Tilia Ellendorff. Ursprünglich habe ich Grundschullehramt mit den Fächern Englisch und Deutsch studiert an der Universität Paderborn. Anschliessend habe ich mich aber entschlossen, mich auf Linguistik und Computerlinguistik zu konzentrieren – zunächst mit einem Bachelor in Linguistik, dann mit einem Internationalen Masterstudium in Computerlinguistik in Wolverhampton (GB) und Faro (P), über Erasmus Mundus. Schliesslich bin ich für das Doktorat in Computerlinguistik nach Zürich gekommen. Mein Thema war Biomedical Text Mining – in meinem Projekt ging es darum, in medizinischen Publikationen die Beziehung zwischen ätiologischen, also auslösenden, Faktoren von psychiatrischen Erkrankungen zu extrahieren. Hier besteht nämlich das Problem, dass es unmöglich ist, die gesamte Literatur auf diesem Gebiet zu lesen. Es ist schwierig, so einen Überblick über alle Faktoren zu gewinnen. Ich habe dazu ein System gebaut, das dies unterstützt und automatisch aus den Texten extrahiert. [Gerold Schneider, GS]: Ich habe Englische Literatur- und Sprachwissenschaft und Computerlinguistik an der Universität Zürich studiert. Während des Doktorats habe ich einen syntaktischen Parser für Englisch entwickelt. Es ist ein System, das eine syntaktische Analyse eines Texts liefert: Was ist das Subjekt, was das Objekt, welches die untergeordneten Sätze, etc. Mit der Anwendung dieses Tools bin ich schliesslich in das Gebiet des Text Minings gelangt. Zunächst habe ich das auch zu Fachliteratur im biomedizinischen Bereich angewendet. Die gleichen Methoden konnte ich später in weiteren Disziplinen verwenden, z.B. in Projekten mit dem Institut für Politikwissenschaft im NCCR Democracy zu Demokratieforschung, oder auch in einem Projekt zu Protestforschung. Dabei geht es ja nicht nur um eine Faktensammlung, sondern meist um Meinungen, Stimmungen oder Assoziationen, die aus den Medien extrahiert werden müssen: Gerade da braucht man statistische Methoden, mit logikbasierten stösst man nur auf Widersprüche. Somit sind auch die Methoden des maschinellen Lernens unerlässlich. Die Daten und Ergebnisse müssen zum Schluss aber auch interpretiert werden können – sonst nützt die Datensammlung nicht viel. Mein breiter Hintergrund ist hier sicher von Vorteil – ich sehe mich auch als Brückenbauer zwischen Disziplinen.

[Gerold Schneider, GS]: Ich habe Englische Literatur- und Sprachwissenschaft und Computerlinguistik an der Universität Zürich studiert. Während des Doktorats habe ich einen syntaktischen Parser für Englisch entwickelt. Es ist ein System, das eine syntaktische Analyse eines Texts liefert: Was ist das Subjekt, was das Objekt, welches die untergeordneten Sätze, etc. Mit der Anwendung dieses Tools bin ich schliesslich in das Gebiet des Text Minings gelangt. Zunächst habe ich das auch zu Fachliteratur im biomedizinischen Bereich angewendet. Die gleichen Methoden konnte ich später in weiteren Disziplinen verwenden, z.B. in Projekten mit dem Institut für Politikwissenschaft im NCCR Democracy zu Demokratieforschung, oder auch in einem Projekt zu Protestforschung. Dabei geht es ja nicht nur um eine Faktensammlung, sondern meist um Meinungen, Stimmungen oder Assoziationen, die aus den Medien extrahiert werden müssen: Gerade da braucht man statistische Methoden, mit logikbasierten stösst man nur auf Widersprüche. Somit sind auch die Methoden des maschinellen Lernens unerlässlich. Die Daten und Ergebnisse müssen zum Schluss aber auch interpretiert werden können – sonst nützt die Datensammlung nicht viel. Mein breiter Hintergrund ist hier sicher von Vorteil – ich sehe mich auch als Brückenbauer zwischen Disziplinen.

Mein Name ist Daniel Ursprung, ich bin wissenschaftlicher Mitarbeiter an der Abteilung für Osteuropäische Geschichte am Historischen Seminar. Dort bin ich in der Forschung und Lehre aktiv – in der letzten Zeit habe ich mich, v.a. im Bereich der Lehre, mit digitalen Technologien und deren Möglichkeiten auseinandergesetzt. Ich möchte den Studierenden einen niederschwelligen Einstieg in diese Technologien ermöglichen.

Mein Name ist Daniel Ursprung, ich bin wissenschaftlicher Mitarbeiter an der Abteilung für Osteuropäische Geschichte am Historischen Seminar. Dort bin ich in der Forschung und Lehre aktiv – in der letzten Zeit habe ich mich, v.a. im Bereich der Lehre, mit digitalen Technologien und deren Möglichkeiten auseinandergesetzt. Ich möchte den Studierenden einen niederschwelligen Einstieg in diese Technologien ermöglichen.