Was haben Vektoren mit Sprache zu tun? Martin Volk, Rico Sennrich und Simon Clematide sprechen mit mir über Methoden der Computerlinguistik. In dieser Reihe geben Lehrende und Forschende der PhF uns einen Einblick in Forschungsprojekte und Methoden «ihrer» Digital Humanities und zeigen uns, welche Technologien in ihrer Disziplin zum Einsatz kommen. Wir diskutieren den Begriff «Digital Humanities» von ganz verschiedenen Perspektiven aus.

Wir sprechen heute zu viert über Computerlinguistik und Digital Humanities – können Sie sich alle kurz vorstellen?

[Martin Volk, MV]: Starten wir in alphabetischer Reihenfolge…

[Simon Clematide, SC]: Ich bin wissenschaftlicher Mitarbeiter am Institut für Computerlinguistik, ursprünglich studierte ich Germanistik, Informatik und Philosophie. Ich habe also humanistisch angefangen und wurde immer technischer – mein Doktorat machte ich dann in der Computerlinguistik. Ich habe den Wandel der Computerlinguistik mitgemacht von eher wissensbasierten Systemen, in denen man linguistische Kenntnisse brauchte, zu eher statistischen und maschinellen Lernverfahren. Ich sehe mich als Brückenbauer zwischen den geisteswissenschaftlichen und den eher technischen Ansätzen.

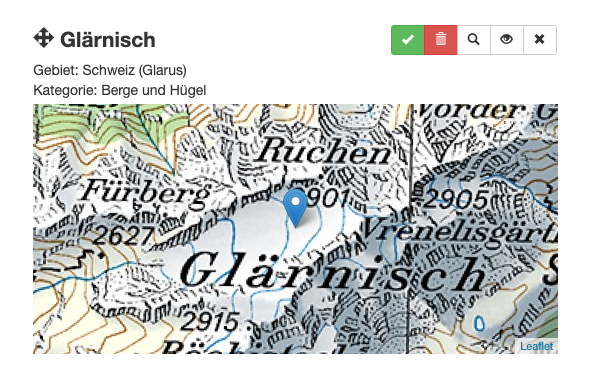

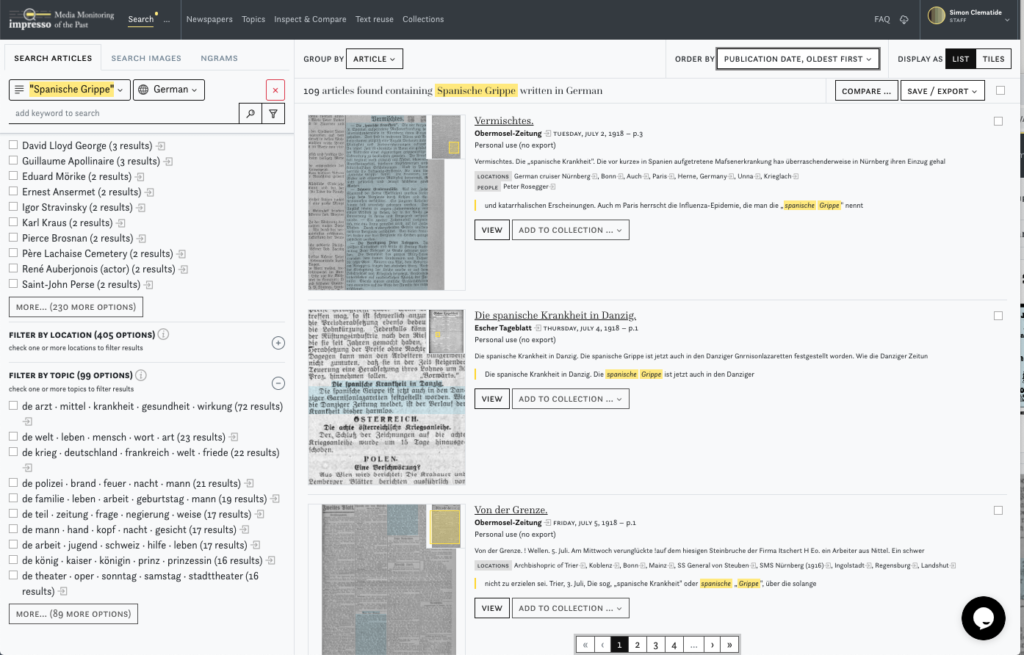

Aktuell arbeiten Martin Volk und ich zusammen mit Forschenden aus den digitalen Geschichtswissenschaften am Projekt Impresso, einem vom SNF unterstütztes Sinergia Projekt, in dem Techniken der Textanalyse, die v.a. für zeitgenössische Dokumente entwickelt wurden, in grossem Stil auf schweizerische und luxemburgische Zeitungen aus den letzten 250 Jahren angewendet werden. Dabei werden die mehrsprachigen Inhalte der Zeitungen möglichst gut indiziert, damit interessierte Personen diese effizient durchsuchen können.

Ein weiteres laufendes Projekt ist der Stellenmarkt-Monitor Schweiz zusammen mit Prof. Marlis Buchmann vom Soziologischen Institut im Rahmen des (Nationalen Forschungsprogramms 77 “Digitale Transformation”): Hier analysieren wir Stellenanzeigen inhaltlich – welche Fähigkeiten werden verlangt, welche Aufgaben werden beschrieben, wie widerspiegelt sich die Technologieentwicklung der letzten Jahre, wie haben sich die Berufe verändert?

Beiden Projekten ist gemeinsam, dass sie eine Textanalyse brauchen und der Text für die Maschine lesbar und interpretierbar gemacht werden muss: Dieses Fachwissen bringen wir mit.

[Rico Sennrich, RS]: Ich bin SNF-Förderprofessor am Institut für Computerlinguistik – meine Forschungsinteressen sind die Anwendung und Entwicklung maschineller Lernverfahren für die Sprachverarbeitung, insbesondere im Bereich Multilingualität. Einerseits geht es hier um die maschinelle Übersetzung, andererseits aber darum, Modelle zu entwickeln, die multilingual funktionieren: Konkret wird ein Modell auf mehreren Sprachen trainiert, so dass es schliesslich besser funktioniert, als wenn man separate Modelle für jede Sprachen trainieren würde. Sogar der Transfer zu Sprachen, für die keine oder nur wenige Texte für eine Anwendung vorhanden sind, ist möglich.

Ich bearbeite nicht direkt geisteswissenschaftliche Fragestellungen, aber die Methoden, an denen ich arbeite, können durchaus auch in den Geisteswissenschaften Anwendung finden. Im Projekt x-stance mit dem Doktoranden Jannis Vamvas ging es dieses Jahr z.B. darum, zunächst Datensätze zu generieren und Modelle zu entwickeln, die multilingual sind. Die Datensätze bestanden aus Kommentaren von Politiker/-innen, die mit Annotationen «positiv/negativ» in Bezug auf bestimmte Fragestellungen versehen wurden. Wir konnten dann zeigen, dass das Modell auf verschiedene Fragestellungen und verschiedene Sprachen trainiert werden kann: D.h. wurde es auf deutsche und französische Kommentare trainiert, hat die Analyse danach auch für die italienischen gut funktioniert.

Gerade solche Methoden können z.B. auch für die Politikwissenschaften interessant sein: Mit wenig Annotationsaufwand können dann Analysen über mehrere Sprachen hinweg betrieben werden.

[Martin Volk, MV]: Ich studierte in den 80er Jahren Informatik und Computerlinguistik, war in den 90er Jahren Postdoc an der UZH und konnte in dieser Zeit schon mit Simon Clematide zusammenarbeiten. Später war ich einige Jahre als Professor in Stockholm, seit 2008 bin ich als Professor und Institutsleiter am Institut für Computerlinguistik wieder an der UZH. Rico Sennrich war bei uns am Institut Doktorand – wir drei kennen uns also schon einige Jahre.

Meine Forschungsschwerpunkte haben sich über die Jahre etwas verschoben. In den 90er Jahren hatten wir wissens- und regelbasierte Systeme und versuchten, Grammatiken zu schreiben, um die grammatische Struktur von Sätzen z.B. automatisch zu bestimmen: Wo ist ein Prädikat, wo ist ein Subjekt, ein Objekt? Als später die statistischen Verfahren kamen, merkten wir, dass es mit diesen Verfahren viel besser funktioniert.

Eine der Ideen, mit denen ich 2008 aus Schweden zurückgekommen bin, war, die Arbeit an der maschinellen Übersetzung zu intensivieren. Früher war der Aufwand dafür schlicht zu gross: Man musste zehntausende von Wörtern in ein Lexikon eintragen, um Sätze analysieren zu können. Nun können wir Systeme für die Analyse selbst bauen.

Ob dies zum Bereich der Digital Humanities gehört, ist die Frage. Und wenn es schon um Definitionen geht – in Diskussionen über Digital Humanities habe ich einmal gesagt, es sei «doing new things with old texts». Eine Person meldete sich und fragte, was denn mit neuen Texten sei? Meine Antwort war: «Doing new things with new texts» – das ist Computerlinguistik! Das ist aber natürlich meine ganz eigene Sicht auf die Welt…

Ein konkretes Projekt im Bereich Digital Humanities, an dem ich gerade arbeite, ist die Digitalisierung des Bullinger-Briefwechsels: Von Heinrich Bullinger sind ca. 12’000 Briefe erhalten, von denen einige Tausend von der Theologischen Fakultät bereits ediert worden sind – wir versuchen nun, den Rest auch noch zu digitalisieren. Dies geschieht mit automatischer Handschriftenerkennung und maschineller Übersetzung der frühneuhochdeutschen und lateinischen Texte in modernes Deutsch.

Der Übergang von wissensbasierten Systemen zu statistischen – ist dies genau der Wandel von den Lexika mit zehntausenden Einträgen zu maschinellen Methoden, auch Machine Learning Methoden?

[MV]: Genau, und dies kann man gerade am Beispiel der maschinellen Übersetzung gut sehen. In den wissensbasierten, d.h. regelbasierten Systemen musste man diese grossen Lexika, Wörterbücher haben, um überhaupt analysieren zu können, wie ein Eingabesatz aufgebaut ist. Im nächsten Schritt wurde er dann erst in die Zielsprache transferiert, um dann schliesslich einen «gültigen» Satz daraus zu generieren. Da war unglaublich viel Handarbeit involviert, um die Wörterbücher und die Entsprechungsregeln zu erstellen.

Heute braucht man dagegen eigentlich «nur» grosse Mengen an bereits erfolgten Übersetzungen, z.B. zehn Millionen Sätze, die in einer hohen Qualität bereits übersetzt wurden. Daraus kann der Computer dann lernen, wie Übersetzungen zu machen sind.

Entwickeln Sie in der Computerlinguistik diese Modelle für das Maschinelle Lernen selbst?

[RS]: Das ist eine Gemeinschaftsarbeit der Community, und es freut mich sehr, wie offen das Wissen geteilt wird. Es werden stetig kleine Verbesserungen am Werkzeugkasten des Maschinellen Lernens vorgenommen – auch das Institut für Computerlinguistik hat schon Teile dazu beigetragen, die nun auch von anderen Gruppen verwendet werden. Umgekehrt verwenden wir Sachen, die andere beigetragen haben.

Welches «Werkzeug» haben Sie da konkret entwickelt?

[RS]: Bei unserem Beitrag ging es darum, wie Texte für die maschinellen Lernverfahren repräsentiert werden. Intern werden die Texte als Vektoren, also als Zahlen repräsentiert. Aus technischen Gründen muss man dann mit relativ kleinen Vokabularen, d.h. ca. 10’000 Wörtern arbeiten – für die Sprachverarbeitung reicht das nirgends hin, weil wir bei Sprachen mit hunderttausenden oder gar Millionen unterschiedlichen Wörtern arbeiten möchten. Wir haben dann einen Algorithmus entwickelt, um Wörter in kleinere Stücke aufzuteilen, sogenannte «Subworteinheiten», mit denen man später alle Wörter im Vokabular repräsentieren kann. Dieses Tool wird nun fast überall in der Community eingesetzt, wenn es um die Verarbeitung von Sprachen in neuronalen Netzen geht.

[MV]: Dieses Verfahren des «Byte Pair Encoding» wurde am Institut für Computerlinguistik und der Universität in Edinburgh entwickelt – das Paper von Rico Sennrich ist derzeit übrigens eines der meistzitierten Papers in der Computerlinguistik.

[RS]: Das Paper heisst Neural Machine Translation of Rare Words with Subword Units, das tönt vielleicht etwas spezifisch, doch das Verfahren wird auch ausserhalb der maschinellen Übersetzung verwendet, oder auch, wenn es nicht speziell um seltene Wörter geht. Es geht darum, ein offenes Vokabular haben zu können, d.h. alle Wörter repräsentieren zu können, und das mit einem beschränkten Vokabular von Symbolen.

Herr Clematide – verwenden Sie ähnliche Methoden in Ihren Projekten?

[SC]: Nicht konkret dieses Verfahren… Was uns aber verbindet, sind die Vektorrepräsentationen der Wörter, die es nicht einfach gibt, sondern aus grossen Textsammlungen «gelernt» werden müssen. Dies ist sicher die grosse Erfindung der Sprachtechnologie und war ein grosser Treiber des Fortschritts. Es ist ein grosser Bruch in der Art und Weise, wie wir mit Sprache umgehen – mathematische Modelle haben «Überhand» gewonnen.

[MV]: Dazu möchte ich ein Beispiel geben. Auch vor 20 Jahren wurde ein Wort numerisch im Computer repräsentiert. Nimmt man z.B. die Wörter «Haus» und «Gebäude», wurden diese mit einer Bytesequenz repräsentiert – heute haben wir aber eine numerische Repräsentation, mit der man automatisch berechnen kann, dass «Haus» und «Gebäude» bedeutungsmässig sehr eng beieinander liegen, während «Haus» und «Fussball» sehr viel weiter auseinander liegen. Das Neue ist also eine numerische Repräsentation, die die Bedeutungsähnlichkeit repräsentiert – und dies nicht manuell zu machen, sondern aus grossen Textmengen automatisch zu erschliessen.

Was ist eigentlich der Unterschied zwischen Supervised und Unsupervised Learning? Können Sie das für Laien erklären?

[RS]: Der Hauptunterschied ist der, ob man dem Modell schon vorgibt, was es zu suchen hat, oder ob das Modell dies selbst herausfindet. Konkret heisst das: Beim Supervised Learning gebe ich dem Modell ein Set von Annotationen – nur dieses Set kann es als Output produzieren. Beim Unsupervised Learning wird eine Datenmenge eingegeben, das Modell findet dann vorhandene Strukturen selbst, nimmt also ein Clustering ähnlicher Wörter vor.

[MV]: Wenn der Computer lernen soll, wo im Text ein Personenname steht, kann man entweder hingehen und in einigen Texten manuell sagen: Das ist ein Personenname, das ist einer, etc., markiert also um die 10’000 Personennamen. Dies ist dann ein supervisiertes Datenset. Der Computer kann daraus dann lernen, was Personennamen sind und in welchen Kontexten sie vorkommen. Dadurch kann er schliesslich Namen erkennen, die so noch nie vorgekommen sind – weil sie in ähnlichen Kontexten vorgekommen sind.

Was ist die spezielle Schwierigkeit bei einer multilingualen Analyse, oder besser gesagt: Was ist anders als bei einsprachigen Modellen?

[RS] Es geht um die Frage, wie man zu den Annotationen kommt. Wir haben gehört, dass hier oft die Arbeit von Menschen dahintersteckt, das macht es manchmal etwas unausgewogen: Bei gewissen Sprachen gibt es annotierte Daten für verschiedenste Fragestellungen, bei anderen wiederum fast gar nichts. Im Projekt x-stance, von dem wir bereits gehört haben, haben wir die Annotationen bestehender Datensätze extrahiert: In der smartvote-Plattform, von der die politischen Kommentare stammen, gibt es eine numerische Klasse für die Aussagen «Ja, ich stimme zu», «Nein, ich stimme nicht zu». Für Deutsch konnten wir 50’000 Kommentare extrahieren, für Französisch 15’000, bei Italienisch waren es dann nur noch 1000. Mengenmässig gibt es also einen grossen Unterschied. Maschinelle Lernverfahren sind recht datenhungrig – wenn wir uns nur auf Italienisch stützen würden, hätten wir Schwierigkeiten. Was Martin Volk mit «Haus» und «Gebäude» zuvor angesprochen hat, kann man auch mehrsprachig machen: So sind «Haus» und «casa» inhaltlich ebenfalls sehr nahe beieinander. Wenn man die Ähnlichkeiten einmal hat, kann man das Modell auf den deutschen und französischen Daten trainieren und bekommt recht gute Ergebnisse auch für die italienischen Datensätze. Im Moment sind die Ergebnisse für Italienisch 70% korrekt, das ist wahrscheinlich für Politikwissenschaftler/-innen noch nicht gut genug – aber wir machen Fortschritte.

Können diese Modelle für die geistes- oder sozialwissenschaftlichen Disziplinen ohne Anpassungen weiterverwendet werden oder muss da jede Disziplin ein spezifisches Modell entwickeln?

[SC] Die Geisteswissenschaften gehen häufig mit traditionellen intellektuellen Methoden an ein Thema heran, manchmal denken sie dann, man könne mit den Methoden der Sprachtechnologie «die mühsamen Arbeiten» effizienter erledigen. Wir wissen, dass die Methoden aber immer auch Fehler produzieren – die Sprache ist einfach zu kompliziert. Deshalb ist das Stichwort «Co-Design» in diesem Zusammenhang wichtig: Wir, die «Technologen», müssen die Methoden auf die echten Probleme und Fragestellungen der Geisteswissenschaftler/-innen hin anpassen. Sie müssen im Gegenzug sehen, dass man ihre Forschungstradition nicht immer «tel quel» automatisieren kann.

[MV] Wir können natürlich nicht über geisteswissenschaftliche Fragestellungen entscheiden, doch dazu einladen, die Chancen zu sehen, wenn wir ihnen helfen, z.B. nicht nur 100 Bullinger-Briefe zu analysieren, sondern 12’000.

Würden Sie denn auch sagen, dass der Mehrwert für die Geistes- und Sozialwissenschaften dann ist, dass man einerseits diese riesige Menge verarbeiten kann, aber auch ganz neue Cluster erkennt, die man mit einer kleinen Auswahl nicht erkannt hätte?

[MV] «Menge» klingt immer ein wenig nach quantitativ statt qualitativ… Ich würde eher argumentieren, dass die grosse Menge besser empirisch abgestützte Ergebnisse ermöglicht. Bei 100 Briefen kann man sicher eine sehr genaue Aussage über diese 100 Briefe machen, aber über die Gesamtheit der Briefe kann man gar keine Aussage machen, höchstens spekulieren. Durch die Verfahren, die wir einbringen, wird das Ergebnis fundierter, weil man die Hypothesen über die Gesamtheit prüfen kann.

Wie kommen die Kollaborationen mit den anderen Instituten überhaupt zustande – funktioniert das über einzelne Forschungsprojekte oder gibt es eine Plattform, wo man sich vernetzen kann?

[MV] Ich bekomme ungefähr jede zweite Woche eine Anfrage für Kollaborationen innerhalb und ausserhalb der UZH. Viele Anfragen müssen wir ablehnen – allein aus Ressourcengründen. Glücklicherweise hat uns die Universitätsleitung eine Förderung für eine Sprachtechnologie-Beratungsstelle zugestanden. Diese hat am 1. September ihre Arbeit aufgenommen, das Text Crunching Center unter der Leitung von Gerold Schneider. Diese Stelle ist dafür da, andere Institute und Seminare der UZH, aber auch Partner von ausserhalb zu unterstützen, Dienstleistungen anzubieten, Projekte aufzugleisen…

Sehr schön, darüber werden wir sicher in einem späteren Beitrag noch berichten! Wie sieht es denn mit der Infrastruktur aus, gibt es eine Zusammenarbeit mit S3IT, die an der UZH «Rechenpower» anbietet?

[MV] Ja, Rico Sennrich ist dort im Aufsichtsrat mit dabei… S3IT kann Hardware zur Verfügung stellen oder eine Software-Empfehlung geben, doch die Art von Knowhow, die wir in der Sprachtechnologie anbieten können, wird nicht von S3IT abgedeckt. Diese Lücke wollten wir mit dem Text Crunching Center füllen. Dabei soll erwähnt werden, dass auch LiRI, die Linguistic Research Infrastructure, ähnliche Dienstleistungen und Beratung anbietet.

In der Computerlinguistik werden Programmierkenntnisse schon auf Bachelorstufe unterrichtet – natürlich. Denken Sie, dass dies auch für andere Disziplinen wichtig wäre?

[MV] Wir beobachten hier schon einen Wandel an der UZH. Alle Studierenden, die den Monomaster Linguistik absolvieren – selbst, wenn sie sich z.B. eher für Historische Sprachwissenschaften interessieren – müssen jetzt neu Programmieren lernen. Auch in der Weiterbildung, z.B. im Studiengang Bibliotheks- und Informationswissenschaft, den die Zentralbibliothek Zürich durchführt, wird ab dem nächsten Durchgang Programmieren gelernt: Von der Einführung in Python bis hin zu Datenstrukturen, etc. Die Anzahl der Personen, die zumindest ein technisches Grundwissen haben werden, wird sich vergrössern.

Wie grenzen Sie sich von der Linguistik ab, wenn dort nun auch programmieren gelernt wird?

[MV] Unsere Fragestellungen sind sehr ingenieurwissenschaftlich ausgerichtet: Wie kann ich einen Algorithmus effizienter machen, wie kann ich eine Repräsentation mächtiger machen, etc.? Das interessiert die Linguisten nicht unbedingt, wenn die Fragestellung ist, ob Sprache X in Indonesien mit Sprache Y in Indien verwandt ist. Das heisst, dass die grundlegenden Fragestellungen andere sind. Uns geht es um die Werkzeugentwicklung und die Effizienz der Werkzeuge. In der Anwendung dieser Werkzeuge in den unterschiedlichen Szenarien, die wir eben vorgestellt haben, gibt es dann Bereiche, die sich überschneiden.

Wir haben zu Beginn schon eine Definition von Digital Humanities von Martin Volk gehört – wie sehen Sie das, Simon Clematide und Rico Sennrich? Was ist das für Sie und «machen» Sie überhaupt Digital Humanities?

[RS] Für mich sind Digital Humanities geisteswissenschaftliche Fragestellungen mit digitalen Methoden, vielleicht mit der Ausnahme der Linguistik. Wenn es linguistische Fragestellungen mit digitalen Methoden sind, passt das auch in die Computerlinguistik. Die Fragestellungen, mit denen ich mich beschäftige, gehören nicht direkt zu den Digital Humanities, da ich eher an den Werkzeugen arbeite.

[MV] Die Arbeiten zur maschinellen Übersetzung, die wir in den letzten 15 Jahren gemacht haben, kann man nicht zu den Digital Humanities im engeren Sinne rechnen, das sind z.T. sehr anwendungsbezogene Fragestellungen, teilweise haben wir auch Grundlagenforschung gemacht. Wird die maschinelle Übersetzung aber angewendet, um die Bullinger-Briefe zu übersetzen, würde ich sagen, dass dies eine Fragestellung der Digital Humanities ist. Für mich ist es immer am Nützlichsten, mir die historische Dimension vorzustellen: Dort sind wir im Bereich der DH, während wir eher im Bereich Computerlinguistik sind, wenn wir an kontemporären Materialien arbeiten. Doch ich weiss, dass viele gerne das Label «Digital Humanities» auch für aktuelle Fragestellungen bzw. Fragestellungen zu aktuellen Texten verwenden – da will ich mich nicht streiten.

Ich habe ursprünglich Germanistik, Neuere Literatur studiert. Gehören dann z.B. textanalytische Fragen im Bereich der Neueren Literatur für Sie auch nicht zu den Digital Humanities?

[MV] Die Arbeiten, die wir Computerlinguisten für die Fragestellung machen würden, sicher nicht, dies wäre eine sprachtechnologische Fragestellung. Was aber für Sie als Germanistin interessant ist, das kann dann durchaus Digital Humanities sein, weil das vielleicht ganz neue Zugänge in Ihrem Feld sind…

Herr Clematide, möchten Sie dazu auch etwas ergänzen?

[SC] Wenn wir Methodenentwicklung machen, ist das Interesse, welche konkrete Fragestellung damit gelöst wird, nicht ganz so wichtig für uns. Man zeigt mit einem Datenset, dass die Methode z.B. 2% besser funktioniert als die andere – das Forschungsinteresse ist ein anderes.

Zum Glück ist «Digital Humanities» ein Kaugummi-Begriff, es gibt eine Community, die sich an Digital Humanities Konferenzen trifft. Die Richtung wird eher sein – denke ich -, dass es in Richtung «Digital Scholarship» geht und jedes Fach ein digitales Toolset aufbauen und in ihre Grundlagenmethoden einbauen wird.

Auch wenn wir eher Methodenentwickler sind, sind wir doch transdisziplinär interessiert – unsere Forschung soll ja nicht für die Schublade sein, sondern auf die Bedürfnisse unseres Gegenübers angepasst werden. Was den Prozess des «Co-Designs» betrifft, sehen wir im Moment sicher eine Professionalisierung und Institutionalisierung an der UZH: Mit dem Institut für Computerlinguistik für die Methodenentwicklung, dem Text Crunching Center für Beratungen, S3IT für die Hardware – die ganze Landschaft hat sich wirklich professionalisiert, und es wird spannend sein zu sehen, wie das Früchte trägt.

Haben wir etwas noch nicht besprochen?

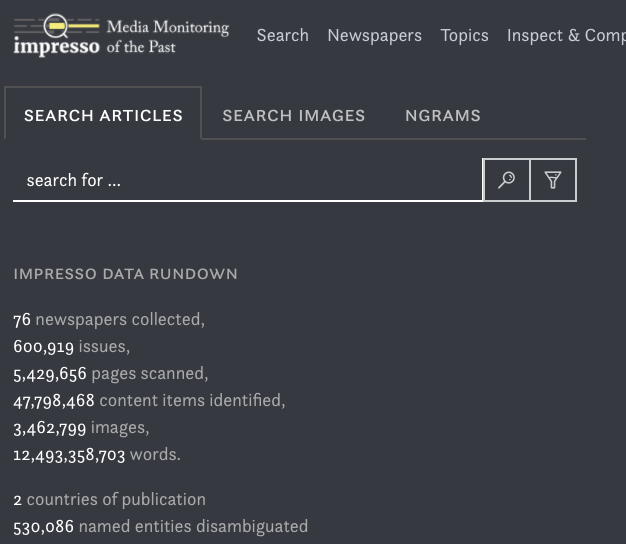

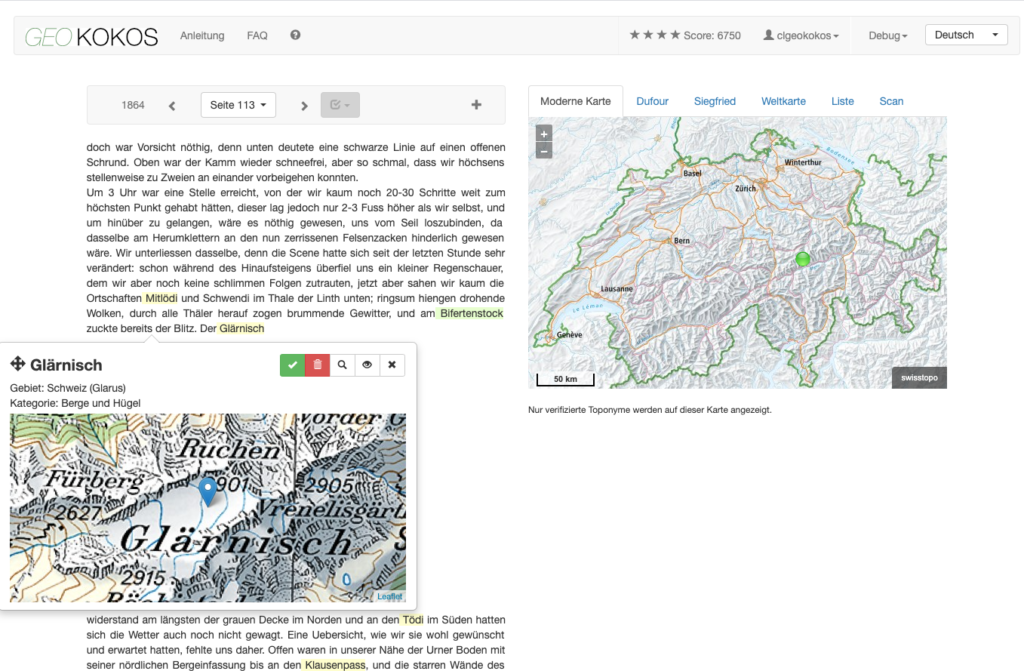

[MV] Ja, eine Sache möchte ich noch unterbringen. Es ist ein Projekt, das uns im Bereich Digital Humanities ein wenig bekannt gemacht hat: Text+Berg digital. Dabei handelt es sich um ein Digitalisierungsprojekt, das wir 2008 gestartet haben. Wir haben die Jahrbücher des Schweizer Alpen-Clubs SAC digitalisiert und aufbereitet. Es entstanden daraus schöne Kooperationen, einerseits mit dem SAC, aber auch mit dem Geographischen Institut, die vor allem an den geographischen Referenzen in den Texten interessiert waren: Gletschernamen, Bergnamen usw.

Patricia Scheurer hat dazu in der Germanistik eine schöne Dissertation verfasst, in der sie sich mit den Metaphern rund um den Begriff «Berg» beschäftigt hat. Ebenso gab es eine Reihe schöner Arbeiten in der Computerlinguistik selbst. Für mich ist es ein schönes Beispiel, wie die Ressourcenerstellung durch uns (die Aufbereitung der Texte) zu einer unglaublichen Menge von Kollaborationen in verschiedenen Disziplinen geführt hat.

Vielen Dank für das Gespräch!

Im Text erwähnte Projekte und Technologien:

https://www.stellenmarktmonitor.uzh.ch/de/research/projects/digital-transformation-nrp77.html

https://github.com/ZurichNLP/xstance

https://www.aclweb.org/anthology/P16-1162/

https://github.com/rsennrich/subword-nmt

https://www.cl.uzh.ch/en/TCC.html